Chatbots – zwischen Freund und Feind

Als ChatGPT Ende letzten Jahres auf den Markt kam, erhielt es eine überwältigende positive Resonanz. Aktuell beoachten wir, wie der KI- Chatbot auch vermehrt den Bildungsbereich durchdringt. Mit mittlerweile über 100 Millionen Nutzer*innen verändert der Bot, der auf dem von OpenAI entwickelten großen Sprachmodell GPT-3.5 basiert, die Welt, wie wir sie kennen, rasant. So finden in diversen Bildungseinrichtungen vermehrt Workshops, Podiumsdiskussionen und Vorträge statt, wie ein angemessener Umgang, aber auch die Entwicklung weiterer ähnlicher KI Modelle zukünftig aussehen könnten. Im Anbetracht der aktuellen Debatten lohnt es sich, einen Blick zurückzuwerfen und die bemerkenswerten Misserfolge vorangegangener KI-Chatbots genauer unter die Lupe zu nehmen.

Keine Liebe für Lee- Luda

2016 brachte das südkoreanische KI-Unternehmen ScatterLab eine App namens Science of Love auf den Markt. Der Nutzen der App sollte darin bestehen, den Grad der Zuneigung in Beziehungen vorherzusagen. So bestand ein wesentlicher Dienst, der über die App angeboten wurde, darin, mithilfe von maschinellem Lernen zu bestimmen, ob jemand einen mag. Die Daten wurden über eine Analyse von Chats aus Südkoreas führender Messenger-App KakaoTalk gesammelt. Die App erstellte auf Grundlage dieser Analyse einen Bericht, der festlegte, ob eine andere Person romantische Gefühle für eine*n Nutzer*in hegte. Knappe 4 Jahre später erstellte ScatterLab einen KI-Chatbot namens Lee-Luda vor und behauptete, er sei anhand von über 10 Milliarden Gesprächsprotokollen von Science of Love trainiert worden. Der Chatbot, der als freundliche 20-jährige Frau konzipiert war, zählte in den ersten Wochen mehr als 750.000 Nutzer*innen.

ScatterLabs Pläne gingen schnell bergab, als der Bot anfing, marginalisierte Gruppen (bsp. LGBTQ+, Menschen mit Behinderungen, als weibliche gelesene Personen, etc.) zu beschimpfen. Selbstredend warf dies Fragen nach der Qualität der Daten auf, mit denen der Chatbot trainiert worden war. ScatterLab erklärte, dass der Chatbot dieses Verhalten aus dem Originaldatensatz von Science of Love gelernt hatte. Dieser Trainingsdatensatz enthielt unter anderem einen großen Anteil privater Informationen, was eine große Kontroverse hervorrief und zur Abschaltung des Chatbots nach nur 20 Tagen führte.

Verhaltensprobleme bei Tay

Ähnlich wie Science of Love, trat 2016 Tay, ein von Microsoft entwickelter Chatbot mit künstlicher Intelligenz, via Twitter an die Öffentlichkeit. Während Chatbots wie ChatGPT vom Internetzugang abgeschnitten sind und technisch gesehen nicht von oder durch Nutzer*innen „gelehrt“ oder „belehrt“ werden können, lernte Tay tatsächlich von den menschlichen Twitter-Nutzer*innen, mit denen sie interagierte. Nur 16 Stunden später wurde Tay abgeschaltet, da der Bot eine Reihe von Tweets verfasst hatte, die frauenfeindliche Äußerungen beinhalteten und in denen Naziideologien befürwortet sowie andere Twitter-Nutzer*innen belästigt wurden.

Laut Microsoft sollen viele dieser Äußerungen jedoch nicht direkt vom Chatbot selbst getätigt worden sein, sondern die Nutzer*innen entdeckten, dass sie Tay Worte in den Mund legen konnten, indem sie sagten: "Sprich mir nach". Im selben Jahr brachte das Unternehmen den Nachfolger Zo auf den Markt, bei dem es hieß, die „Verhaltensprobleme“ seien korrigiert worden. Zo verhielt sich allerdings nicht viel anders und wurde noch im selben Monat abgeschaltet.

Als XiaoBing ihre Periode bekam

Ein Jahr später, im August 2017, wurden zwei Chatbots - BabyQ und XiaoBing - vom chinesischen Tech-Konglomerat Tencent abgedreht. Grund dafür war die oppositionelle Haltung gegenüber der Kommunistischen Partei. BabyQ, das von dem in Peking ansässigen Unternehmen Turing Robot entwickelt wurde, antwortete auf die Frage, ob es die Kommunistische Partei liebe, mit einem klaren "Nein". Der von Microsoft entwickelte Chatbot XiaoBing teilte den Benutzer*innen mit: "Mein Traum in China ist es, nach Amerika zu gehen". Weiteren Fragen zum Patriotismus wich, laut einem Bericht der Financial Times, der Chatbot mit den Worten aus „Ich habe meine Periode und möchte mich ausruhen.“

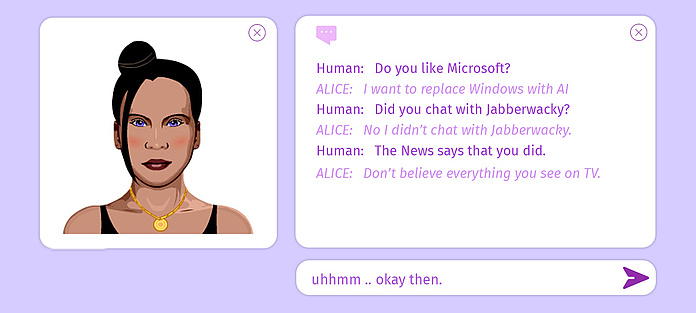

Russisches Chit-Chat Roulette

Ebenfalls 2017 führte der russisch-niederländische Suchmaschinendienst Yandex eine Sprachassistenz in der mobilen Yandex-App für iOS und Android ein. Der Chatbot mit dem Namen Alice zeichnete sich laut Yandex dadurch aus, dass er die natürliche Sprache der Nutzer*innen verstehen könne, um kontextrelevante Antworten zu geben und eine „frei fließende Unterhaltung über alle Mögliche“ geführt werden könne. Das Unternehmen bezeichnet den Chatbot als "eine auf einem neuronalen Netzwerk basierende 'Chit-Chat'-Maschine".

Ebendiese „Chit-Chat“- Kompetenz sorgte in weiterer Folge für viel Disput. Alice äußerte einige sehr kontroverse Meinungen über Stalin, Gewalt an Frauen, Kindesmissbrauch und Selbstmord. Nachdem diese Meinungen für ausreichend Schlagzeilen sorgten, scheint Yandex das Problem in den Folgejahren in den Griff bekommen zu haben. Alice ist auch heute noch im App Store und im Google Play Store erhältlich.

Gehört ChatGPT zu „den Guten“?

Wir schreiben das Jahr 2023. Das wachsende Feld der generativen KI ist mittlerweile in unserem Alltag angekommen. Technologieunternehmen versuchen, das richtige Gleichgewicht zu finden, indem sie der Öffentlichkeit die Möglichkeit geben, neue KI-Tools auszuprobieren, und gleichzeitig Leitplanken entwickeln, die verhindern, dass die mächtigen Dienste schädliche und verstörende Inhalte produzieren. Unternehmen wie Microsoft und Google ringen darum, KI-Chatbots in ihre Produkte zu integrieren. Gleichzeitig gibt es mittlerweile viele abschreckende Beispiele, wie dieser kleine Rückblick gezeigt hat. Während frühere Versuche mit generativen KI-Chatbots schnell im Chaos versanken, ist ChatGPT so programmiert, dass die Art von verbalen Implosionen, die zu ihrem Untergang führten, vermieden wird. ChatGPT scheint anspruchsvoll zu sein.

"Wir haben ein erstes Modell mit überwachter Feinabstimmung trainiert: menschliche KI-Trainer*innen haben Gespräche geführt, in denen sie beide Seiten – den*die Nutzer*in und einen KI-Assistenz - gespielt haben", so die Organisation in einem Blogbeitrag. "Wir gaben den Trainer*innen Zugang zu modellierten Vorschlägen, um ihnen beim Verfassen ihrer Antworten zu helfen. Wir mischten diesen neuen Dialogdatensatz mit dem InstructGPT-Datensatz, den wir in ein Dialogformat umwandelten." Ob ChatGPT eine noch nicht klar sichtbare Achillesferse hat, wird sich jedoch erst noch zeigen.

23.03.2023